Wegweiser Digitale Lehre

© Rawpixel.com / shutterstock

Sie fragen sich, welche Potentiale in digital unterstützter Lehre stecken? Welche digitalen Tools bei bestimmten Herausforderungen in der Lehrpraxis weiterhelfen können? Ob es bewährte Konzepte digital unterstützter Lehre für konkrete Lehrveranstaltungsformate bzw. Lehrszenarien gibt? Wie groß der Aufwand jeweils dafür ist? – Kurzum: Sie wünschen sich eine Art Wegweiser durch den Dschungel der Möglichkeiten digitaler Lehre?

Auch wenn es keine einfachen, schnellen Antworten auf diese Fragen und auch keine Patentrezepte gibt, wollen wir doch versuchen Ihnen innerhalb unserer Beitragsreihe „Wegweiser Digitale Lehre“ Anregungen und Hilfestellungen zu geben, indem wir konkrete Fragen aus dem Lehralltag beantworten.

In diesem Beitrag befassen wir uns mit der Frage:

Wie kann ich den zeitlichen Aufwand für die Korrektur meiner Klausur verringern?

Ausgangssituation:

- mehr als 100 Studierende nehmen an der Klausur teil

- ein Teil der Klausur besteht aus Single- bzw. Multiple Choice oder Zuordnungs-Fragen

- mehrere Mitarbeiter_innen sind mehrere Tage mit der Korrektur beschäftigt (inkl. Übertragung und Berechnung der Daten in Excel)

Kurz zusammengefasst:

An der TU Darmstadt haben Sie die Möglichkeit Ihre Klausur als sogenannte Scan-Klausur durchzuführen. Dabei wird die Prüfung am Computer mithilfe einer Scan-Klausursoftware erstellt und anschließend auf Papier ausgedruckt den Studierenden wie gewohnt im Hörsaal zur Prüfung vorgelegt. Nach dem Einscannen der ausgefüllten Prüfungsbögen werden diese automatisch von der Klausursoftware ausgewertet. Die automatisierte Erkennung funktioniert anhand der Kreuze, die durch die Studierenden bei Single, Multiple Choice und Zuordnungsfragen als Antwort gesetzt werden sowie anhand der Kreuze, die von der prüfenden Lehrperson zur Bewertung von offenen Fragen in die zugehörige Bewertungsfeldmatrix eingetragen werden.

Mithilfe der Scan-Klausursoftware können folgende Aufgaben automatisiert durchgeführt werden:

- Auswertung von Single, Multiple Choice und Zuordnungsfragen

- Zusammenzählen der Punkte (und generieren der Note)

- Erstellen einer Daten-Übersichtstabelle zur Weiterverarbeitung (z.B. für weitere statistische Auswertungen, Dokumentation, Notenimport ins Campus Management System TUCaN)

- Generieren von statistischen Qualitätsdaten (Schwierigkeit, Trennschärfe) und deren Aufbereitung in einem Report

Haben Sie mehr als 100 Prüflinge in Ihrer Klausur, so können Sie mit einer Scan-Klausur den zeitlichen Aufwand für die Korrektur deutlich verringern.

Didaktische Überlegungen:

Um die Korrekturzeit für Klausuren zu optimieren wird häufig auf Fragen im sogenannten Antwort-Wahl-Verfahren (AWV) zurück gegriffen. Dazu gehören beispielsweise Single und Multiple Choice Fragen sowie Zuordnungsfragen. Anhand von Musterantworten lassen sich diese auf Papier bspw. mit einer Schablone oder automatisiert in einem System schnell und objektiv auswerten. Zeiteffizienz und Auswertungsobjektivität sind somit starke Argumente für die Verwendung von AWV-Fragen in Klausuren. Ebenso entfällt bei AWV-Fragen gegenüber offenen Frageformaten die Schreibarbeit für die Studierenden, so dass mehr Prüfungsaufgaben möglich sind. Dadurch kann ein breiteres Spektrum an Inhalten abgedeckt werden, was sich wiederum positiv auf die Reliabilität der Prüfung auswirken kann.

Jedoch werden AWV-Fragen gleichzeitig auch häufig als „zu leicht“ angesehen, da je nach Gestaltung der Frage eine gewisse Ratewahrscheinlichkeit bei der Beantwortung besteht sowie Inhalte von den Studierenden nicht frei reproduziert bzw. erarbeitet werden müssen, um die Frage zu beantworten. Die weit verbreitete Meinung bezüglich AWV-Fragen ist somit, dass mit diesen in der Regel nur Faktenwissen und Lernleistungen auf der Ebene von Erinnern/ Wiedererkennen geprüft werden können.

Mit einer gut durchdachten und kreativen Aufgabengestaltung lassen sich diese Herausforderungen für AWV-Fragen jedoch meistern:

Komplexer Aufgabenstamm

Durch eine komplexere Gestaltung des Aufgabenstamms (bspw. Szenarienbeschreibung, Einbindung von zu analysierenden Tabellen/ Grafiken/ Textauszügen) anhand dessen die Frage beantwortet werden soll, wird es möglich im Sinne von Bloom’s Lernzieltaxonomie auch Lernziele auf höherem kognitiven Niveau zu überprüfen – wie Verstehen und Anwenden, ggf. auch Analysieren.

>> Das Zentrum für Multimedia in der Lehre (ZMML) von der Universität Bremen hat hierzu Tipps und Tricks zur Prüfung höherer Lernzielniveaus zusammen gestellt. <<

Anzahl und Plausibilität der Antwortoptionen

Die Ratewahrscheinlichkeit einer Prüfungsfrage wird stark durch die Anzahl der Antwortoptionen und die Plausibilität der Falschantworten (Distraktoren) beeinflusst. In der Regel gilt, je mehr Antwortoptionen es gibt, desto geringer ist die Ratewahrscheinlichkeit (aber: lieber weniger Antwortalternativen als offensichtlich falsche oder triviale Antworten).

>> Im Artikel „Multiple-Choice-Prüfungen an Hochschulen?“ geben Marlit A. Lindner, Benjamin Strobel und Olaf Köller einen Überblick über die Ergebnisse ihrer breit angelegten Literaturrecherche zum Thema. Unter anderem haben sie Maßnahmen im Rahmen der Aufgabenkonstruktion zusammengetragen, um die Ratewahrscheinlichkeit von Prüfungsaufgaben zu minimieren (Abschnitt 4.1, S. 137-138). Dabei werden auch drei Methoden vorgestellt, um plausible Distraktoren zu konstruieren.<<

Guidelines zur Aufgabenerstellung

Insbesondere bei der Formulierung von AWV-Fragen und den zugehörigen Antwortoptionen sollten bestimmte Regeln beachtet werden, die u.a. die Ratewahrscheinlichkeit, aber auch insgesamt die Qualität einer Prüfungsfrage beeinflussen. Beispielsweise kann die Verwendung bestimmter Begriffe (wie z.B. nie, immer, alle, kein, nur), die ungleiche Länge von Antwortoptionen, die inhomogene Nutzung von Fachsprache oder einfach nur grammatikalische Fehler einen unbeabsichtigten Hinweis auf eine richtige oder falsche Antwort geben. Verschiedene Autoren haben hierzu inzwischen (teils empirisch belegte) Konstruktionsregeln aufgestellt.

>> Beispielsweise in der Ausgabe „Prüfungen auf die Agenda!“ von Sigrid Dany, Birgit Szczyrba und Johannes Wildt innerhalb der wissenschaftlichen Buchreihe „Blickpunkt Hochschuldidaktik“ sind Regeln zur Erstellung von MC-Fragen zusammengestellt (Abschnitt 2.3 , S. 97/98). Ebenso haben wir in unserem Leitfaden für Scan-Klausuren (siehe auch unten „Tipps & Tricks) einen Überblick zu Gestaltungsrichtlinien zusammen gestellt.<<

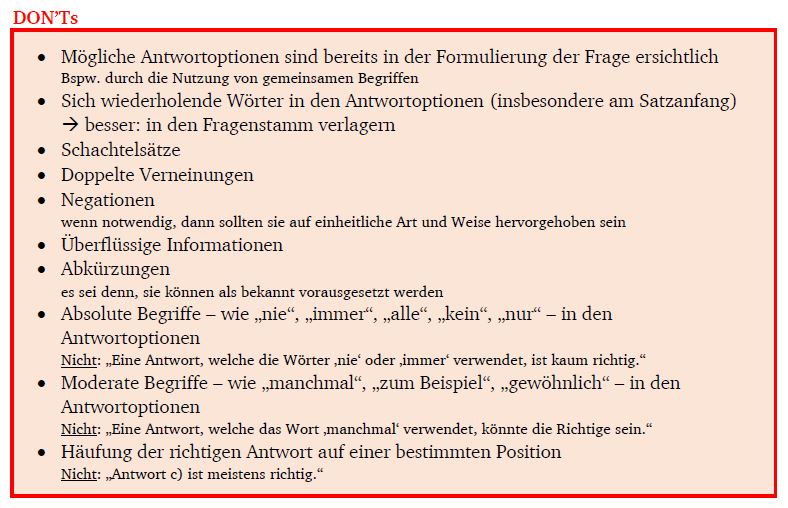

- Empfehlungen zur MC-Aufgabenkonstruktion: DOs

- Empfehlungen zur MC-Aufgabenkonstruktion: DON’Ts

Constructive Alignment

Voraussetzung aller Überlegungen für die Gestaltung von Prüfungsfragen ist die Anwendung des Constructive Alignment Prinzips; d.h. die Lehr- und Lernaktivitäten innerhalb einer Lehrveranstaltung als auch die zugehörige Prüfung sind auf die vorher festgesetzten Lernziele abgestimmt. Empfohlen wird daher für jede Frage festzulegen, welches Lernziel mit dieser überprüft werden soll. Dies wiederum hilft für die Ausgestaltung der Prüfungsfrage.

Werkzeug:

An der TU Darmstadt steht zur Durchführung von Scan-Klausuren das webbasierte System EvaExam zur Verfügung. Dieses ist ein Produkt der Firma Electric Paper, welche ebenfalls das System EvaSys anbietet, das an der TU bereits jahrelang für Evaluationen und Online-Umfragen genutzt wird.

Per Anfrage an die E-Learning-Arbeitsgruppe erhalten Lehrende der TU einen Account zur Nutzung von EvaExam. Bei Bedarf wird ebenso eine Einführung ins System sowie Beratung und Support angeboten, um von „herkömmlichen“ Klausuren auf Scan-Klausuren umzustellen.

Good Practice:

Dr. Christiane Brockmann (Fachbereich Bau- und Umweltingenieurwissenschaften, Institut IWAR) führt Scan-Klausuren in mehreren Lehrveranstaltungen verschiedener Größen durch (I: 450-500 Prüfunglinge; II: knapp 100 Prüfunglinge; Nachklausuren: 40-60 Prüflinge). Ihre Prüfungen bestehen aus einem Teil Single Choice Fragen, aus einem Teil Offener Fragen sowie einem Teil mit Lückentextfragen (die ebenfalls als offenes Frageformat umgesetzt sind).

Frau Brockmann stellt einen eindeutigen Zeitgewinn ab ca. 100 Prüflingen fest und schätzt darüberhinaus die folgenden Vorteile, die auch bei weniger Prüflingen wirksam werden:

- Qualitätsreport

- Fragenbibliothek

- Scans der Prüfungsbögen zur „schnell einsehbaren“ Dokumentation

- Verringerung von Übertragungsfehlern

- individualisierte Klausurbögen (durch Import der Prüfungsteilnehmerliste vorm Erzeugen der Prüfungsbögen)

Als herausfordernd sieht sie an, dass die Formatierung der Fragen in EvaExam teilweise wenig komfortabel ist und nur eingeschränkte Möglichkeiten zur Layoutgestaltung bestehen.

Tipps & Tricks:

Im §22a der Allgemeinen Prüfungsbestimmungen (APB) der TU Darmstadt ist festgelegt, welche Regelungen es bezüglich Prüfungsleistungen im Antwort-Wahl-Verfahren gibt. Die wesentlichen Regelungen sind:

- AWV-Aufgaben sollen den Anteil von 50 % der Gesamtpunktezahl nicht übersteigen.

- Für jede Teilfrage muss klar sein, wie viele Antwortmöglichkeiten richtig sind.

- Es gibt entweder volle Punkte oder gar keine Punkte pro Teilaufgabe.

- Es dürfen keine negativen Punkte vergeben werden.

Hilfreiche Informationen zu AWV-Aufgaben (u.a. mit Beispielen für zulässige sowie unzulässige Aufgabenstellungen) werden auf der Website des Dezernat II (Studium und Lehre) bereitgestellt.

In unseren Leitfäden für Scan-Klausuren geben wir ergänzend zum Bedienerhandbuch zu EvaExam Erfahrungswerte sowie Tipps & Tricks weiter. Diese werden von uns stetig aktualisiert. Der jeweilige Stand wird unten in der Fußleiste des Dokuments angezeigt.

- Überblick zum „Leitfaden: Vor der Prüfung“

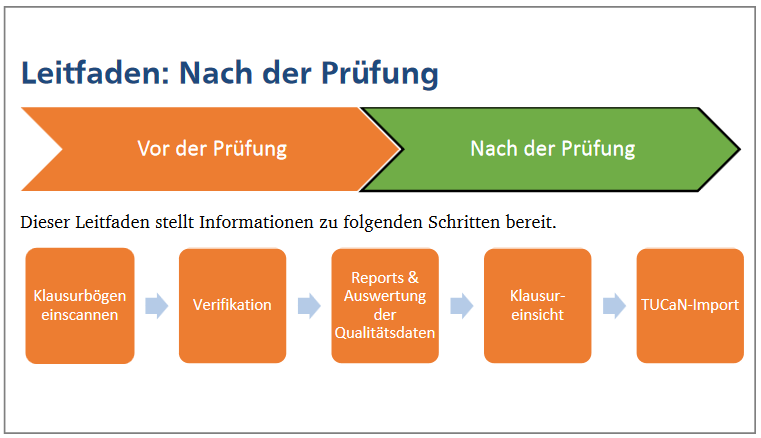

- Überblick zum „Leitfaden nach der Prüfung“

Aufwandseinschätzung:

| Umstellung von „herkömmlicher“ auf Scan-Klausur (initial) | |

| evtl. Neu-Erstellung von AWV-Fragen (initial) | |

| Prüfungsbogenerstellung | |

| Klausurkorrektur (AWV-Fragen) | |

| Zusammenzählen der Punkte | |

| Datenübersichtstabelle zur Weiterverarbeitung erstellen | |

| Noten nach TUCaN übertragen |

Weiterführende Literatur:

Artikel Prüfungen im Antwort-Wahl-Verfahren I, Prüfungen im Antwort-Wahl-Verfahren II auf einfachlehren.de mit ausführlichen Überlegungen dazu:

- welche Vorteile das Multiple Choice Format bietet,

- welche Multiple Choice Fragenformate sich für die Hochschullehre eignen,

- was bei der Formulierung der Aufgaben zu beachten ist

- und wie man Multiple Choice Aufgaben bzw. die Klausur evaluieren kann.

Artikel „Multiple-Choice-Prüfungen an Hochschulen?“ – Ein Literaturüberblick und Plädoyer für mehr Forschung. In diesem 2015 in der Zeitschrift für Pädagogische Psychologie, 29 (3-4) erschienenen Übersichtsartikel stellen die Autoren Marlit A. Lindner, Benjamin Strobel und Olaf Köller die Ergebnisse ihrer Literaturrecherche zu folgenden Fragen vor:

- Wie sieht es mit der diagnostischen Vergleichbarkeit von MC und Offenen Prüfungsformaten aus?

- Wie groß ist das „Rateproblem“ bei MC Prüfungsformaten?

- Welchen Einfluss hat der Einsatz von MC Prüfungsformaten auf die Lern- und Lösungsstrategien der Studierenden?

- Welche MC Prüfungsformate eignen sich für die Hochschulpraxis

Pingback: Designing good teaching with digital support – E-Learning an Hochschulen